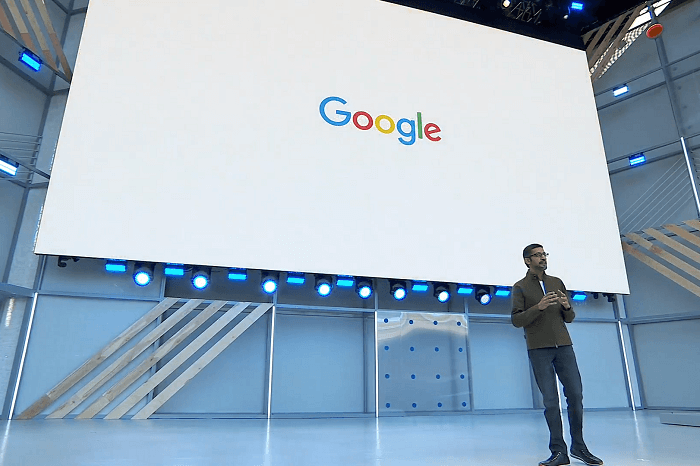

Google hat auf seiner Entwicklerkonferenz I/O Neuigkeiten zum Google Assistant, zu Android P und zu so ziemlich allen anderen Google-Technologien vorgestellt. Vieles wirkt durchdacht, einiges holt die Zukunft be(un)ruhigend nah in die Gegenwart.

Wie weit Google dem Start als reine Suchmaschine mittlerweile entwachsen ist, sieht man dieser Tage auf der alljährlichen Entwicklerkonferenz I/O. Der Google-Kosmos wird stetig größer und er wird offenbar stetig intelligenter. Denn über allem steht auch in diesem Jahr die Künstliche Intelligenz. Und die werde freilich eingesetzt, um das Leben der Nutzer zu verbessern. Man wolle Informationen „nützlicher, leichter verfügbar und besser nutzbar machen“, sagt CEO Sundar Pichai in seiner Keynote. Immer wichtiger wird dabei der Google Assistant.

John Legend als Sprach-Assistent

Besonders mit dem Google Assistant hat man sich in den Unternehmens-Laboren sehr ausgiebig beschäftigt. Diesem werden sechs neue Stimmen spendiert, die natürlicher wirken sollen als bisher. Etwas später in diesem Jahr kommt zudem die Stimme von Popstar John Legend dazu. Der musste dafür nicht monatelang im Tonstudio verbringen. Google ist mittlerweile so weit, die Stimme einfach nachzubauen – inklusive Stimmfarbe und Tonalität. Nützlicher als die neuen Stimmen wird aber der gestiegene Funktionsumfang. Der Nutzer muss künftig nicht mehr jede Interaktion mit „Hey Google“ bzw. „OK Google“ auslösen. Der Assistent soll selbstständig merken, ob er oder jemand anders angesprochen ist, etwa bei Folgefragen. So sollen längere „Unterhaltungen“ natürlicher werden.

Zudem soll der Assistent mit komplexeren Fragestellungen zurechtkommen. Das nennt sich bei Google Multiple Actions und ermöglicht die Beantwortung von Fragen wie etwa „Wie ist das Wetter in Berlin und regnet es in Leipzig?“. Darüber hinaus gibt es viele kleine und größere Verbesserungen. Mit Custom Routines kann sich der Nutzer eigene Routinen basteln, sodass ein „Hey Google, dinner’s ready“ etwa den Fernseher ausschaltet, die Musik startet und der Familie die passende Info auf ihre jeweiligen Bildschirme gibt. Praktisch und wichtig: Die Verzahnung mit Google Maps soll besser werden. Ohne ständig auf die Karte schauen zu müssen, kann der Nutzer etwa per Sprache Nachrichten abrufen, einen Anruf starten und so weiter. Ende des Jahres soll der Google Assistant in 80 Ländern verfügbar sein.

Google Duplex: Wenn der KI-Assistent den Tisch reserviert

Für großes Aufsehen in Zusammenhang mit dem Assistant sorgte eine Neuheit namens Google Duplex. Dabei übernimmt der Sprachassistent tatsächlich echte Assistenzaufgaben, indem er zum Beispiel Termine vereinbart – via Anruf. Und das so realistisch, dass es fast ein bisschen beunruhigend wirkt. In zwei Beispielen (die man an dieser Stelle nachhören kann) versucht der Google Assistant einen Tisch im Restaurant zu reservieren und vereinbart einen Friseurtermin. Die Anrufempfänger bemerken dabei offensichtlich gar nicht, dass sie gerade nicht mit einem echten Menschen sprechen. Eingestreute „Mmmh“ und „Ähms“ verstärken die Illusion. In den verschiedenen Beispielaufnahmen reagiert der Assistant auf Nachfragen und Unterbrechnungen täuschend echt.

Duplex ist freilich vorerst ein Experiment, das ab Sommer mit einer eingeschränkten Nutzergruppe getestet werden soll. Es ist aber ein interessanter Blick in die Zukunft. Eine echte Unterhaltung mit einer KI ist offenbar nicht mehr so weit entfernt, wie man denken könnte.

Google P: Leg das Smartphone doch mal weg

Das zweite große Thema der I/O ist die neue Android-Version P, die bereits als Beta-Version ausprobiert werden kann. Mit den Neuerungen will Google für einen bewussteren Umgang mit dem Smartphone sorgen und den Nutzer dazu ermutigen, es auch mal beiseitezulegen. Akku und Helligkeit sollen der Nutzung entsprechend automatisch reguliert werden, um mehr Laufzeit herauszuholen. Sogenannte App Actions sollen der Situation entsprechend starten – schließt man etwa Kopfhörer an, kann man wählen, ob man jemanden anrufen oder die zuletzt gehörte Musik fortsetzen möchte. Es soll am unteren Bildrand nur noch einen Home-Button geben, der den Überblick über die aktuell genutzten Apps bietet.

Um die bewusstere Handy-Nutzung zu fördern, spendiert Google seinem Betriebssystem ein neues Dashboard. Dieses gibt zum Beispiel Aufschluss darüber, wie viel Zeit man in Apps verbringt, wie man Notifications bekommt oder wie oft man das Smartphone entsperrt. Bei der reinen Information bleibt es aber nicht. Ein neuer App-Timer gibt die Möglichkeit, Zeit-Limits für bestimmte Apps zu setzen. Außerdem wird die Nicht-Stören-Funktion erweitert. Diese stellt das Gerät nun nicht mehr nur auf lautlos, sondern unterbindet auch visuelle Pop-Ups. Zudem wird sie nun beim Umdrehen des Smartphones automatisch aktiviert. Google will also, dass der Nutzer tatsächlich weniger auf das Smartphone starrt und diese Zeit dann sinnvoller nutzt.

Auch Google News wird klüger

Google News wird grundoptimiert, um den „Qualitätsjournalismus zu fördern“, wie Sundar Pichai sagt. Die KI soll künftig automatisch die für den Nutzer relevantesten Nachrichten aus dem Internet zusammensuchen. Dabei lernt sie mit laufender Nutzung ständig, was für den Einzelnen auch relevant ist. Nicht ganz klar ist allerdings, nach welchen Kriterien die News-Kataloge zusammengesetzt werden, was Google also als Qualitätsjournalismus interpretiert. Das dürfte ein Geheimnis des Algorithmus bleiben.

Google Lens: Die echte Welt ins Smartphone

Neuerungen gibt es auch bei Google Lens, das im vergangenen Jahr vorgestellt wurde. Damit lassen sich über die Smartphone-Kamera Informationen aus der realen Welt verarbeiten und das soll künftig noch besser funktionieren. Lens ist ab sofort direkt in die Kamera-App unterstützter Geräte integriert. Die neue Smart Text Selection ermöglicht es, Texte aus der realen Welt via Copy/Paste zu markieren und in die Google-Suche einzugeben. Sitzt man etwa in einem Restaurant und weiß nicht, was sich hinter einem Gericht verbirgt, lässt sich dieses aus der Karte markieren und Google zeigt dann etwa das passende Bild an. Lens erkennt automatisch Objekte, markiert sie und bietet Zusatzinformationen aus dem Google-Kosmos – und das alles nun in Echtzeit.

Und außerdem gibt es auf der I/O Neuerungen und Erweiterungen zu quasi allen Google-Projekten, von Maps über Gmail bis hin zu neuen Foto-Funktionen. Google klotzt und kleckert nicht, um am eigenen Ruf und am Ruf der Technologie-Branche zu feilen. Das Image des großen Daten-Imperiums gefällt den Kaliforniern offenbar nicht so gut.

Abonnieren

Schreiben Sie einen Kommentar